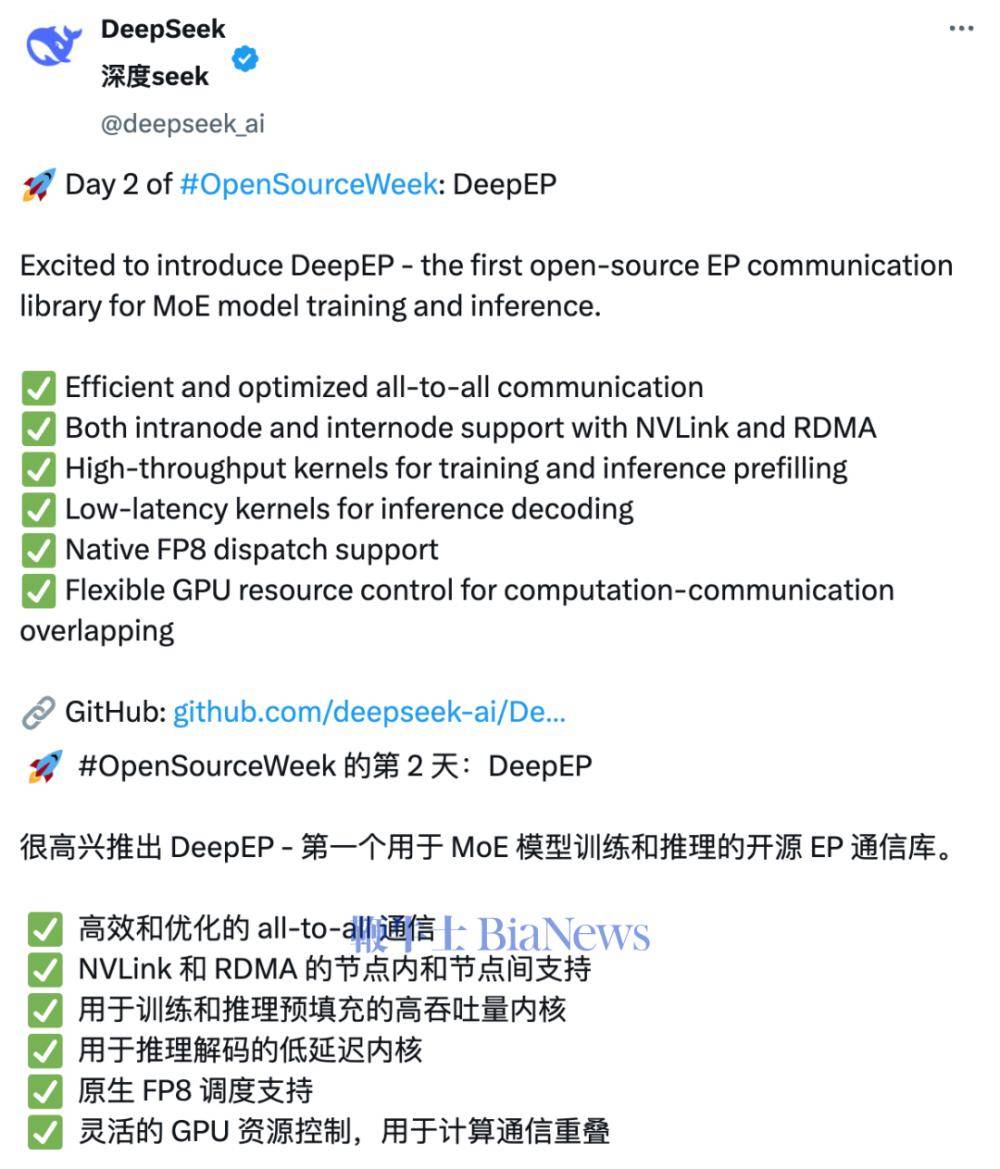

在科技界的持续关注下,一款名为DeepEP的创新开源项目于近日正式发布,该项目由DeepSeek团队在继DeepSeek后的第二天隆重推出。DeepSeek官方通过某社交平台向公众宣布,DeepEP作为全球首个专为MoE(专家混合)模型训练和推理量身定制的EP(专家并行)通信库,其诞生标志着通信技术在AI领域的又一次重大突破。

DeepEP以其卓越的性能和多样化的功能吸引了业界的广泛关注。它实现了高效的全对全(all-to-all)通信机制,不仅支持节点内部(intranode)的数据交换,还跨越节点(internode)进行通信,完美兼容NVLink和RDMA技术。这一特性确保了数据在复杂网络环境下的流畅传输。

在训练和推理过程中,DeepEP展现了其强大的计算能力。预填充(prefilling)阶段采用高吞吐率计算核,显著提升了数据处理速度;而在推理解码(decoding)阶段,则采用低延迟计算核,确保了实时响应的高效性。DeepEP原生支持FP8数据调度,这一低精度计算操作进一步降低了资源消耗,提升了整体性能。

尤为DeepEP在GPU资源管理方面展现出了极高的灵活性。通过巧妙的设计,它实现了计算与通信的重叠处理,有效提高了硬件资源的利用率。这意味着,在使用DeepEP进行MoE模型训练和推理时,用户能够享受到更加流畅和高效的计算体验。

DeepEP专为MoE和EP设计,其核心功能包括高吞吐、低延迟的全对全GPU计算核,这些计算核在MoE的dispatch和combine阶段发挥着关键作用。它们不仅提升了数据传输速度,还确保了数据在处理过程中的准确性和稳定性。DeepEP对低精度计算操作的支持,使得它在处理大规模数据集时更加高效节能。

据APPSO的报道,DeepEP可以被形象地比喻为MoE模型的“通信管家”。它通过软硬件的协同优化,实现了专家之间数据传递的快速与资源节约,从而大幅度提升了训练和推理的效率。这一创新成果不仅为AI领域的研究者提供了强大的工具支持,也为未来的智能应用发展奠定了坚实的基础。