英伟达近日宣布,其最新推出的DeepSeek-R1模型,在AI推理领域树立了新的标杆。这款开放模型以其卓越的推理能力,为用户提供了前所未有的智能体验。

与传统的AI模型不同,DeepSeek-R1并不直接给出答案,而是通过一系列复杂的推理过程,包括思路链、共识和搜索方法,来生成最佳答案。这一过程被称为测试时间扩展,而DeepSeek-R1正是这一扩展定律的杰出代表。它充分展示了加速计算在AI推理中的关键作用。

由于能够反复思考问题,DeepSeek-R1模型在推理过程中会产生更多的输出标记,并延长生成周期。这种特性使得模型的质量不断提高,为用户提供了更高质量的响应。然而,要实现实时推理和更高质量的响应,需要大量的测试时计算,这也对推理部署的规模提出了更高的要求。

DeepSeek-R1在逻辑推理、数学、编码和语言理解等任务中表现出色,其准确性遥遥领先。同时,它还具备高推理效率,能够在短时间内完成复杂的推理任务。

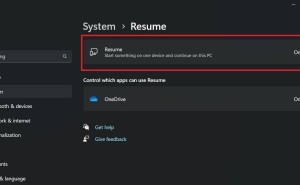

为了让开发人员能够安全地试验这些功能,并构建自己的专用代理,英伟达将6710亿参数的DeepSeek-R1模型作为NVIDIA NIM微服务预览版在build.nvidia.com上提供。这一举措将极大地促进AI推理技术的发展和应用。

据悉,DeepSeek-R1 NIM微服务在单个NVIDIA HGX H200系统上每秒可处理多达3,872个令牌,性能强劲。开发人员可以通过应用程序编程接口(API)进行测试和试验,这一接口预计很快将作为可下载的NIM微服务提供,成为NVIDIA AI Enterprise软件平台的一部分。

DeepSeek-R1 NIM微服务还支持行业标准API,简化了部署过程。企业可以在其首选的加速计算基础设施上运行NIM微服务,以最大限度地提高安全性和数据隐私。通过使用NVIDIA AI Foundry和NVIDIA NeMo软件,企业还可以为专门的AI代理创建定制的DeepSeek-R1 NIM微服务。

这一创新不仅推动了AI推理技术的发展,也为开发人员和企业提供了更加便捷、高效的AI解决方案。随着DeepSeek-R1的广泛应用,我们有理由相信,未来的AI世界将更加智能、更加美好。